Вижу новости, что ChatGPT начал ставить скрытые водяные знаки в текстах: как на самом деле

22 апреля СМИ и телеграм-каналы сообщили, что новые модели в ChatGPT встраивают в ответы специальные символы и тем самым помечают сгенерированный текст.

В соцсетях предположили, что функцию добавили специально, чтобы преподавателям было проще ловить студентов на сгенерированных работах в период зачетов и экзаменов. Но в OpenAI заявили, что водяных знаков не внедряли. Новейшие модели нейросети действительно стали вставлять в текст символы, которые их выдают, но они случайно научились этому сами. Расскажу подробнее.

Что произошло

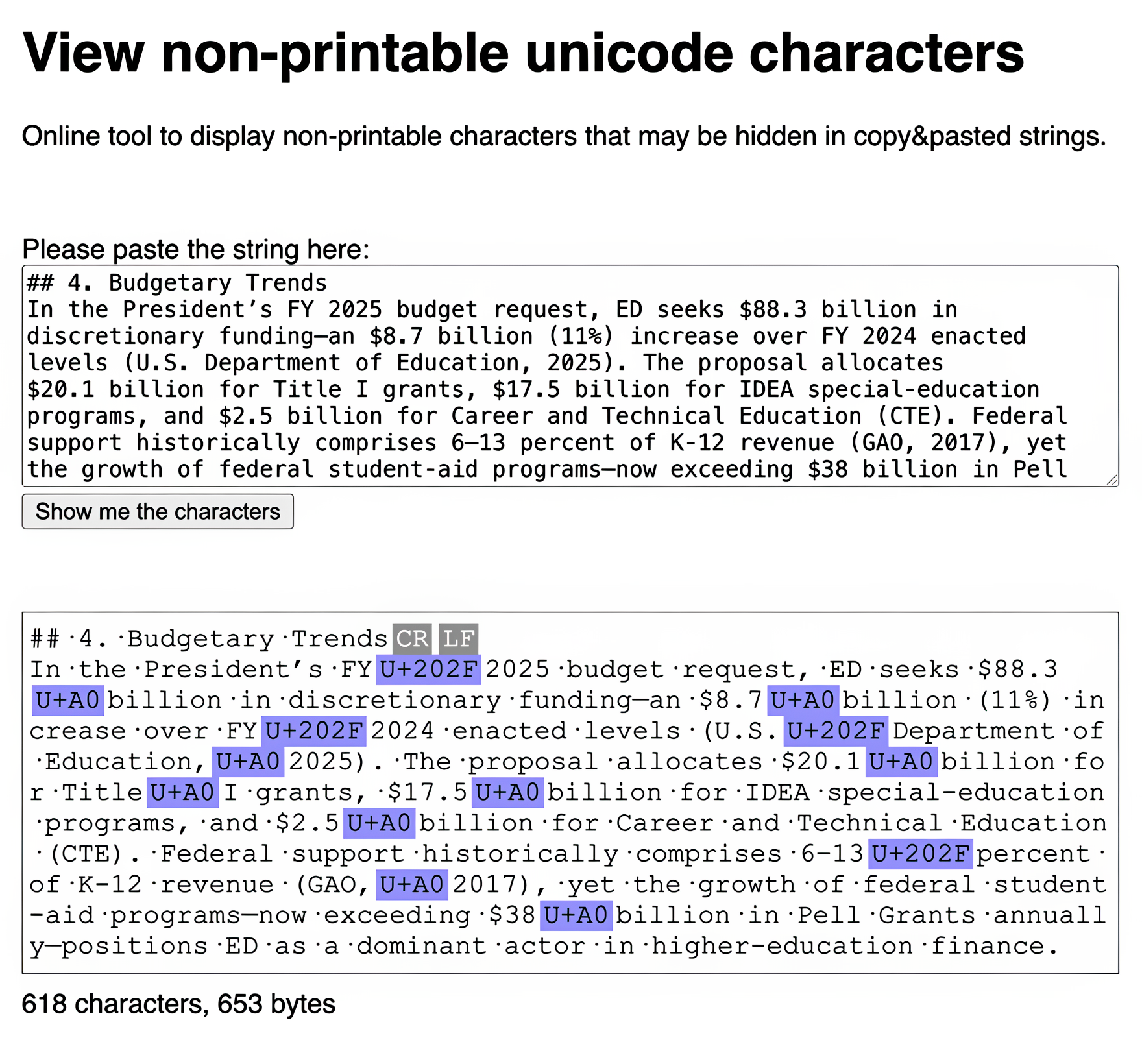

Разработчики платформы для управления политикой использования нейросетей в учебных заведениях Rumi обнаружили, что новые «рассуждающие» модели o3 и o4-mini в ChatGPT встраивают в сгенерированные ответы Unicode-символы. В частности, это неразрывные пробелы, которые отображаются как набор символов «U+202F».

Такие символы не видно в чате с ChatGPT, а также при копировании текста в Microsoft Word, гугл-документы, мессенджеры или браузер. При этом они отображаются в редакторах кода — например, Sublime Text или VS Code.

Во время теста разработчики Rumi обнаружили, что неразрывные пробелы появлялись только в длинных ответах — например, если ввести запрос «Напиши эссе о министерстве образования». Когда ответ умещался в два предложения, лишних символов не было.

Пользователи также заметили, что специальные символы появляются рядом с датами и сокращениями. При этом старые модели вроде GPT-4o вообще не добавляли подобных символов.

В Rumi предположили, что функцию внедрили намеренно. Они посчитали, что таким образом OpenAI начала тестировать водяные знаки для выявления сгенерированных студенческих работ. Якобы учителя могут вставлять текст в редакторы кода и таким образом распознавать, что ученик целиком скопировал текст из ChatGPT.

Такое предположение выдвинули на фоне того, что недавно OpenAI предоставила студентам бесплатный пробный период, который продлится до конца учебного года.

Что ответили разработчики ChatGPT

OpenAI ответила исследователям из Rumi, что неразрывные пробелы — это не водяные знаки. По словам разработчиков, символы появились из-за «особенности масштабного обучения с подкреплением».

Обучение с подкреплением — это когда нейросеть учится принимать решения путем проб и ошибок, получая «награду» за правильные действия. Под масштабным обучением компания имеет в виду, что оно происходит на огромных объемах данных, с миллионами взаимодействий, параметров и сценариев.

OpenAI назвала вставку странных символов побочным эффектом этого масштабного процесса. Модель начала использовать их не по указанию разработчиков, а потому, что так сформировался навык. Возможно, они встречались в тренировочных данных или каким-то образом улучшали отклик модели.

Другими словами, появление специальных символов — это не защита от списывания и не водяные знаки, а «побочный эффект» сложного и масштабного обучения. Модель случайно начала вставлять специальные символы в текст. В то же время в OpenAI не уточнили, будут ли корректировать обучение моделей и «отучать» их от неразрывных пробелов.

При этом OpenAI уже разработала систему водяных знаков для сгенерированных текстов. Но компания отказалась от технологии из-за опасений, что это снизит вовлеченность пользователей и, как следствие, прибыль. Вместо этого они рассматривают возможность добавлять к текстам метаданные.

Как проверить, есть ли неразрывные пробелы в сгенерированном тексте

В текстовых редакторах и браузерах специальные символы выглядят точно так же, как обычные пробелы, поэтому их невозможно отличить невооруженным глазом. Но их можно обнаружить, если скопировать текст:

- в онлайн-инструменты, например SoSciSurvey;

- редакторы кода, например Sublime Text или VS Code;

- примитивные текстовые редакторы вроде «Блокнота».

В этих программах символы будут отображаться на месте обычных пробелов. Так можно определить, что текст был скопирован напрямую из новых моделей ChatGPT без изменений.

Мы постим кружочки, красивые карточки и новости о технологиях и поп-культуре в нашем телеграм-канале. Подписывайтесь, там классно: @t_technocult