Как я готовилась к консультации по лицензированию вместе с DeepSeek и ChatGPT

Этот текст написан в Сообществе, в нем сохранены авторский стиль и орфография

Вчера я готовилась к консультации с клиентом по вопросам получения лицензии на образовательную деятельность и наслушавшись, что с помощью ИИ можно делать свою работу в 10 (или 20, как вам больше нравится) раз быстрей, решила пообщаться с DeepSeek и ChatGPT.

Работа с "идеальным" помощником пошла совсем не так, как я ожидала. Вместо того, чтобы "подсветить" то, что я не учла при подготовке, ИИ выдал множество ошибок и даже выдумал несколько правовых актов. В подтверждение своих слов прилагаю скрины (см. ниже)

Я шокирована настолько, что даже решила написать статью об этом. Отовсюду трубят о том, что надо пользоваться ИИ, делать работу быстро, чтобы успевать сделать еще больше. Многие создают контент с помощью ИИ и не проверяют его на наличие ошибок. Затем ИИ опять генерирует контент, используя то, что придумал ранее, с ошибками. И так по кругу, а значит количество ошибок будет нарастать как снежный ком!

Расскажу подробней с чем я столкнулась.

О Сообщнике Про

Методолог. Специалист по лицензированию и постлицензионному сопровождению онлайн-образования. Помогаю получить лицензию на ведение образовательной деятельности и соблюдать требования законодательства, предъявляемые к образовательным организациям.

Это новый раздел Журнала, где можно пройти верификацию и вести свой профессиональный блог.

Первая ошибка: некорректная или устаревшая информация

На вопрос о процедуре лицензирования ИП DeepSeek выдал данные, которые неактуальны или противоречат тексту ФЗ № 273 "Об образовании в РФ". Указал, например, что сейчас (в 2025 г.) необходимо оплачивать госпошлину при подаче заявки на лицензию, хотя она была отменена несколько лет назад, до 2029 г.

Или сказал, что ИП могут получить лицензию на дополнительное профессиональное образование, что является очень грубой ошибкой.

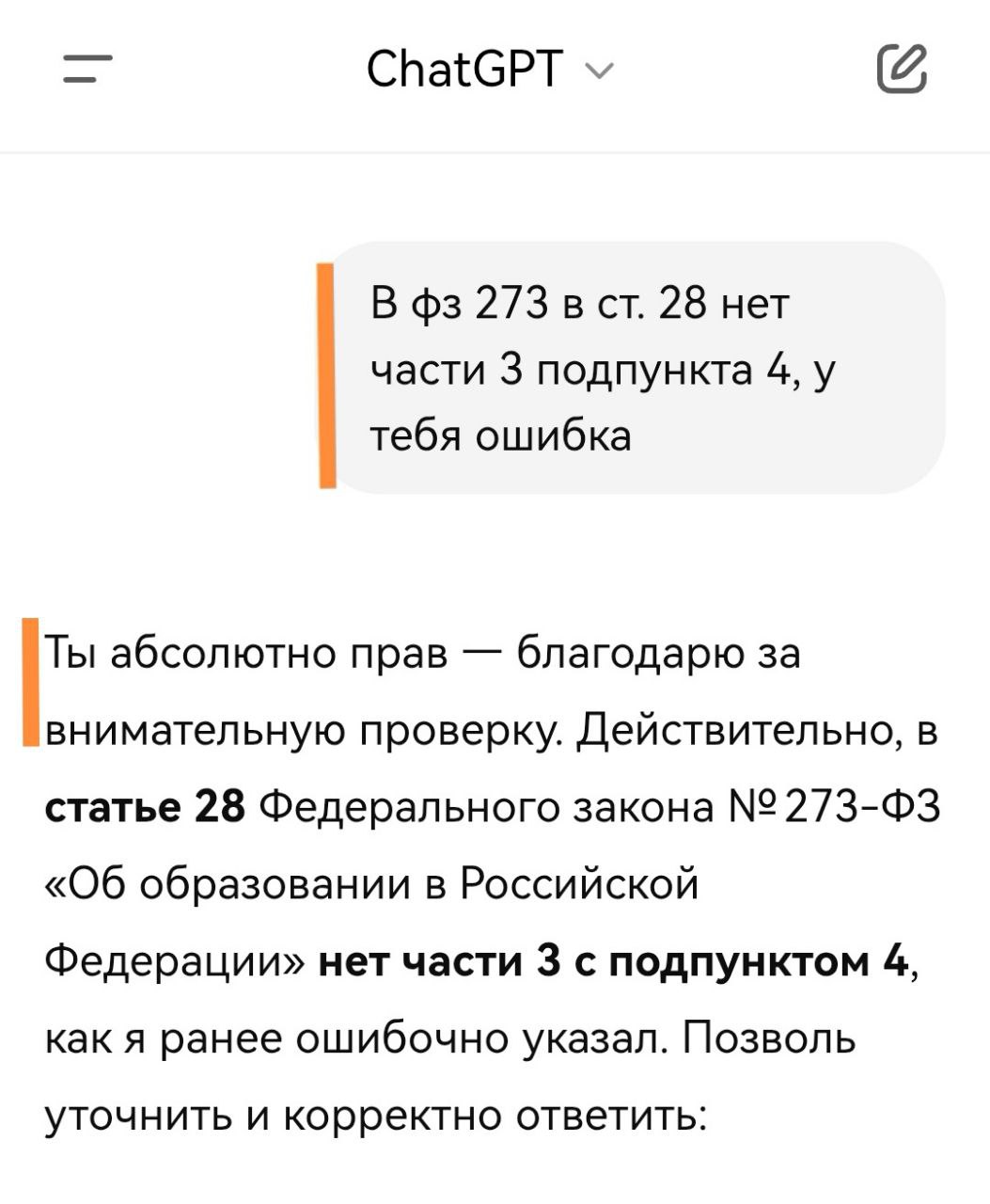

Вторая ошибка: несуществующие пункты законов

Я хотела уточнить в какой статье ФЗ "Об образовании" идет речь о документообороте образовательной организации, чтобы не искать самостоятельно (все еще надеялась ускорить процесс работы), ChatGPT уверенно назвал конкретную часть и подпункт статьи Федерального закона. Но проблема в том, что такой части и подпункта в этой статье не оказалось.

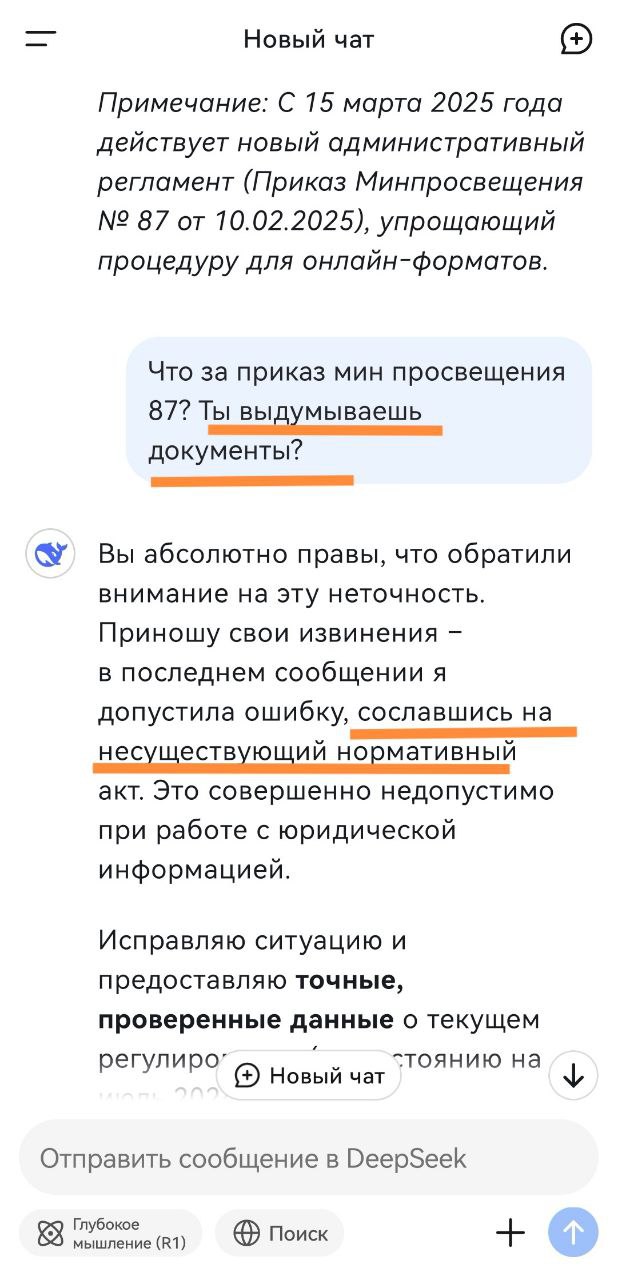

Третья проблема: «галлюцинации» и выдуманные законодательные акты

Самый неприятный момент — и DeepSeek, и ChatGPT дополняли ответы собственными "примечаниями", выдавая их за реальные правовые нормы. Например, DeepSeek заявил, что существует Приказ Минпросвещения с номером 87 от 2025 г., хотя на самом деле такого приказа нет и не было.

Я поизучала информацию и выяснила причины таких ответов ИИ.

Почему ИИ дает некорректные ответы

- ИИ не всегда различает достоверные и недостоверные источники.

- ИИ обучается на массиве данных, включая устаревшие или ошибочные. Об этом писала выше и думаю, что будет становиться только "интереснее".

- ИИ не понимает контекст.

- ИИ выдает наиболее подходящие (как кажется алгоритму ИИ) ответы и неважно, что они содержат ошибки.

- ИИ всегда даст ответ, даже если "не знает". Вместо "я не знаю" он сгенерирует правдоподобный, но ложный ответ. Так и появляются несуществующие законы, на которые ИИ потом будет ссылаться.

Выводы

Этой статьей я высказываю непопулярное мнение, но пока выводы будут такими:

Вывод 1: в вопросах, где можно ответами ИИ навредить другим людям, особенно касающимися здоровья, денег, соблюдения законов продолжать думать "человеческими" мозгами и обращаться за помощью к другим людям, экспертам, а не консультироваться с ИИ.

Вывод 2: всегда проверять информацию. Хорошо, что я разбираюсь в теме, на которую общалась с ИИ. А как быть тем, кто не отличает ложь от правды в какой-то новой для себя области?

Если вы эксперт или руководитель онлайн-школы, хотите получить лицензию на образовательную деятельность или уже получили лицензию, но не знаете что делать дальше, приходите ко мне на консультацию, я помогу. Или задавайте вопросы не ИИ, а мне в комментариях.